Huawei a travaillé avec Cambricon pour développer la partie accélération pour l’intelligence artificielle pour ses derniers processeurs de téléphone, le Kirin 970 (utilisé notamment pour le Huawei P20). Cette partie porte le doux nom de Cambricon-1A et, depuis son annonce l’année dernière, peu de détails étaient disponibles. Cambricon a depuis décidé de continuer la course seul, avec un processeur distinct prévu pour l’intelligence artificielle. Selon les déclarations actuelles, ce processeur serait basé sur le cœur Cambricon-1A du Kirin 970, mais à une bien plus grande échelle.

Huawei a travaillé avec Cambricon pour développer la partie accélération pour l’intelligence artificielle pour ses derniers processeurs de téléphone, le Kirin 970 (utilisé notamment pour le Huawei P20). Cette partie porte le doux nom de Cambricon-1A et, depuis son annonce l’année dernière, peu de détails étaient disponibles. Cambricon a depuis décidé de continuer la course seul, avec un processeur distinct prévu pour l’intelligence artificielle. Selon les déclarations actuelles, ce processeur serait basé sur le cœur Cambricon-1A du Kirin 970, mais à une bien plus grande échelle.

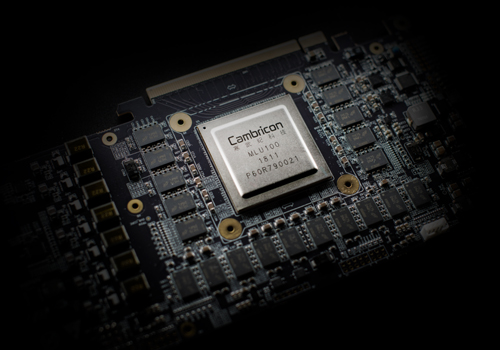

Le MLU-100 peut consommer une puissance de quatre-vingts watts pour effectuer des calculs à raison de soixante-quatre téraflops en demi-précision (seize bits) ou cent vingt-huit téraflops sur des entiers à huit bits. Ces formats de nombre sont relativement peu précis, mais sont très souvent utilisés pour l’implémentation des réseaux neuronaux les plus performants. Le processeur fonctionne normalement à 1 GHz, mais peut monter jusque 1,3 GHz : il pourra alors développer une puissance de calcul de plus de quatre-vingts téraflops (FP16) ou cent soixante-six téraflops (INT8), avec une consommation de cent dix watts (une bien moins bonne efficacité énergétique).

Ces caractéristiques rappellent celles des TPU de Google, qui visent le même marché, mais avec des formats de nombre plus exotiques. La grande différence est cependant qu’il sera possible d’acheter des processeurs de Cambricon (notamment sous la forme d’une carte d’extension PCIe), alors que Google ne s’autorise qu’à en louer de la puissance…

Par rapport aux cartes graphiques de NVIDIA, notamment la dernière génération Volta, on retrouve une puissance de calcul légèrement supérieure, mais avec une consommation bien supérieure — et une programmabilité bien différente. Aussi, quand NVIDIA et Google utilisent de la mémoire HBM2, Cambricon se limite à de la DDR4, alors que bien des applications d’apprentissage profond à grande échelle sont plus vite limitées par la bande passante de la mémoire que par la puissance de calcul.

Il sera bientôt possible d’acheter des machines avec ces accélérateurs déjà installés, par exemple les serveurs ThinkSystem SR650 de Lenovo. D’autres collaborent déjà avec Cambricon pour en profiter, comme Sugon ou iFlytek — toutes trois des sociétés chinoises, tout comme Cambricon.

Source et images : Cambricon, Makers of Huawei’s Kirin NPU IP, Build A Big AI Chip and PCIe Card.

Vous avez lu gratuitement 8 articles depuis plus d'un an.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.